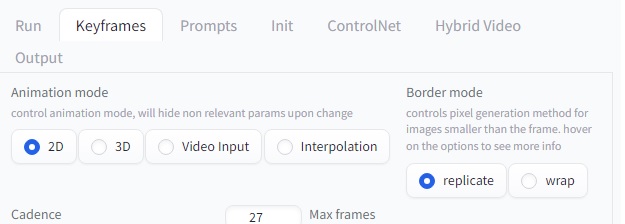

Motion, Noise, Coherence, Anti Blur, Depth Warping & FOV는 Stable Diffusion에서 애니메이션의 다양한 측면을 제어하는 데 사용됩니다. 각각의 요소는 다음과 같은 역할을 합니다:

1. **Motion (움직임)**: 애니메이션 내 객체의 움직임을 조절합니다. 객체의 이동, 회전, 확대/축소 등을 설정하여 움직임을 구현할 수 있습니다.

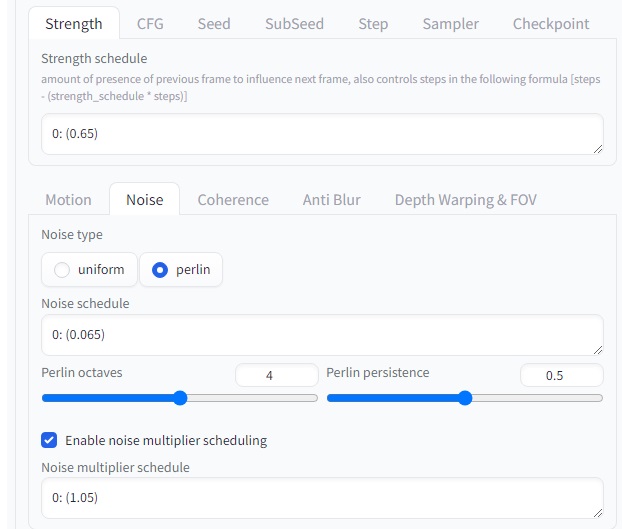

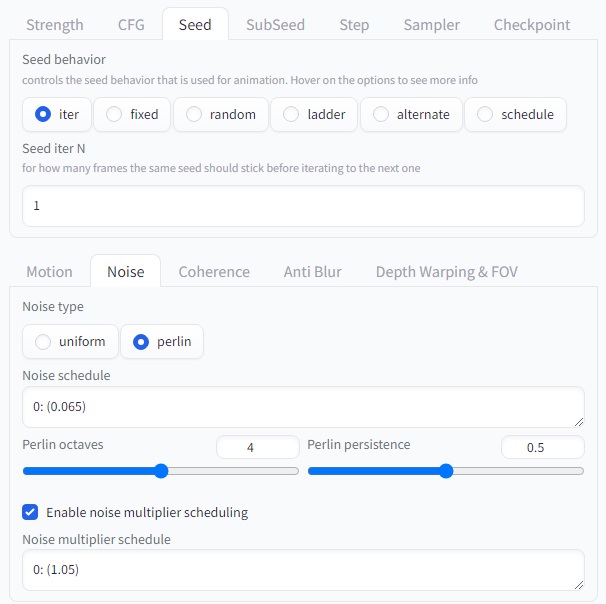

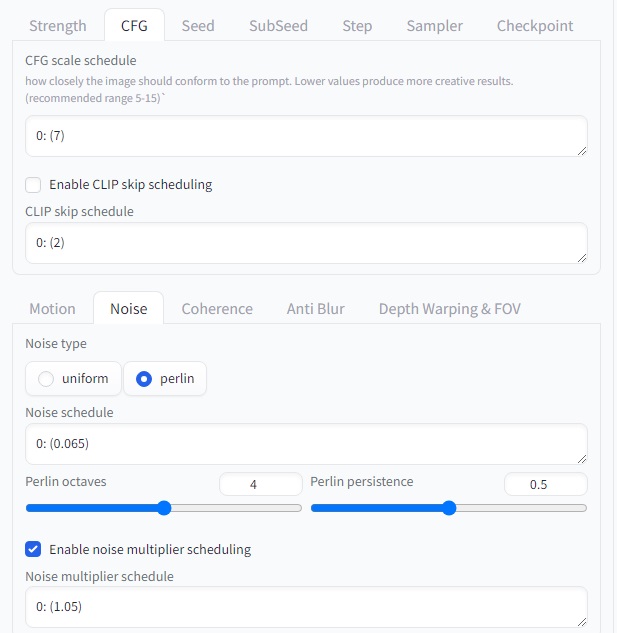

2. **Noise (노이즈)**: 이미지에 추가되는 잡음의 양과 유형을 조절합니다. 잡음을 조절하여 이미지의 질감을 변경하거나 특정 효과를 부여할 수 있습니다.

3. **Coherence (일관성)**: 이미지 내 구조와 패턴의 일관성을 유지하도록 설정합니다. 높은 일관성은 이미지가 안정적이고 일관된 모습을 유지하도록 합니다.

4. **Anti Blur (안티 블러)**: 이미지의 흐릿한 부분을 줄이는 효과를 제어합니다. 높은 값은 이미지가 더 선명하게 보이도록 합니다.

5. **Depth Warping & FOV (깊이 왜곡 및 시야)**: 이미지의 깊이와 시야를 조절합니다. 깊이 왜곡을 통해 이미지에 깊이감을 부여하고, 시야 설정을 통해 시각적인 효과를 변경할 수 있습니다.

이러한 요소들을 조합하여 원하는 애니메이션 효과를 구현할 수 있으며, 각각의 설정은 애니메이션의 다양한 측면을 조절하여 원하는 결과를 얻을 수 있도록 도와줍니다.