LoRA(저랭크 적응, Low-Rank Adaptation)는 대규모 언어 모델의 파라미터 수를 크게 줄이면서도 모델의 성능을 유지하는 방법입니다. 일반적으로 대규모 모델을 훈련시킬 때, 전체 모델을 다시 훈련시키는데는 막대한 비용과 시간이 소요됩니다. LoRA는 이러한 문제를 해결하기 위한 방법으로 개발되었습니다.

일반적으로, 예를 들어 GPT-3 175B와 같이 거대한 언어 모델을 사용할 때, 모델을 특정 작업이나 도메인에 맞게 재조정하려면 독립된 모델을 새로 훈련해야 합니다. LoRA는 이런 부담을 줄이기 위해 개발되었습니다.

LoRA의 아이디어는 기존의 사전 훈련된 모델 가중치를 동결하고, 각 레이어의 파라미터 수를 크게 줄이면서도 모델의 유용성을 유지하는 것입니다. 이를 위해 각 레이어에 훈련 가능한 랭크 분해 행렬을 주입합니다. 이 방식은 모델의 훈련 가능한 파라미터 수를 크게 줄여주는 동시에 메모리 요구량을 줄여줍니다.

결과적으로 LoRA를 적용하면, 파라미터 수를 크게 줄일 수 있으면서도 모델의 품질이 크게 하락하지 않는다는 것입니다. 이는 효율적으로 훈련 가능한 파라미터 수를 줄여 비용을 절감하면서도 모델의 성능을 유지할 수 있는 방법을 제시합니다.

논문.

“Low-Rank Adaptation of Large Language Models” (LoRA)에 대한 논문 요약입니다. 이 논문은 자연어 처리의 중요한 패러다임 중 하나인 일반 도메인 데이터의 대규모 사전 훈련과 특정 작업 또는 도메인에 대한 적응을 다룹니다.

논문에서는 대규모 모델을 사전 훈련할수록 모든 모델 파라미터를 다시 훈련하는 “full fine-tuning”이 점차 더 어려워진다는 문제점을 지적합니다. 예를 들어 GPT-3 175B를 사용한다면, 각각이 175B의 파라미터를 가진 독립적인 fine-tuned 모델을 배포하는 것이 매우 비용이 많이 든다고 합니다.

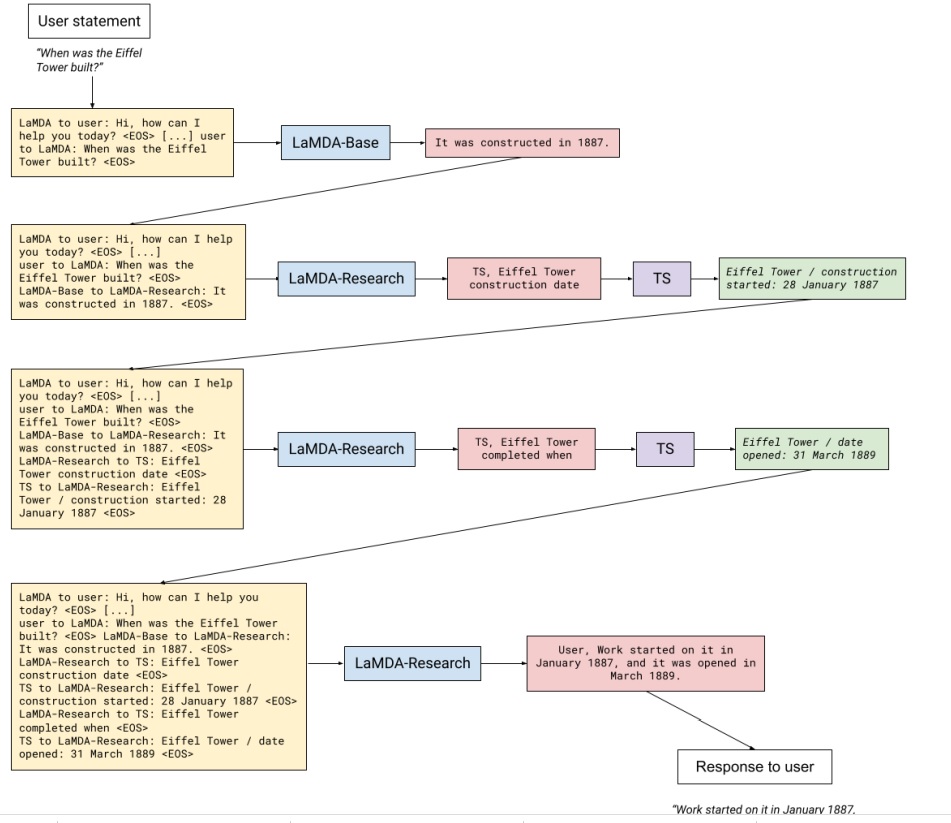

LoRA는 이러한 문제를 해결하기 위해 제안되었는데, 사전 훈련된 모델 가중치를 유지하고 Transformer 아키텍처의 각 레이어에 학습 가능한 랭크 분해 행렬을 삽입하여 하위 작업의 학습 가능한 파라미터 수를 크게 줄입니다. LoRA는 Adam으로 fine-tuning 된 GPT-3 175B와 비교하여 학습 가능한 파라미터 수를 10,000배 줄이고 GPU 메모리 요구량을 3배로 줄일 수 있다고 합니다.

LoRA는 RoBERTa, DeBERTa, GPT-2 및 GPT-3의 모델 품질에서 fine-tuning과 유사하거나 더 우수한 성능을 보이며, 학습량이 더 높고 어댑터와 달리 추가적인 추론 지연이 없습니다. 이를 통해 언어 모델 적응에서 랭크 결핍에 대한 실험 결과를 제공하여 LoRA의 효과를 밝히고 있습니다.

이 논문은 PyTorch 모델과 LoRA를 통합하는 데 도움을 주는 패키지를 제공하고 있으며, RoBERTa, DeBERTa 및 GPT-2의 구현과 모델 체크포인트를 이용할 수 있도록 URL을 제공합니다. 이 논문은 Computation and Language (cs.CL); Artificial Intelligence (cs.AI); Machine Learning (cs.LG) 분야의 arXiv:2106.09685에 출판되었습니다.

더 많은 정보를 원한다면, 해당 링크인 https://doi.org/10.48550/arXiv.2106.09685를 참조할 수 있습니다.