chatGPT API는 텍스트를 입력받아 대화를 생성하는 모델입니다. 이를 교육에 활용할 수 있습니다. 아직 남들이 시도하지 않은 영역을 찾는다면 어떨까요? 예를 들어 바이올린 레슨은 음악적, 기술적 문제 해결을 위해 코칭과 피드백등의 고도의 인간의 상호작용이 필요한 영역입니다. 이 영역을 인공지능으로 도전하는 과정 안내입니다.

시작하기 전 데이터 준비 사항과 배경 지식

- 데이터 수집: ChatGPT API는 대규모 데이터 세트를 필요로 하므로, 바이올린 레슨을 위한 GPT를 만들기 위해서는 바이올린 교본(특히 시노자키 바이올린 교본, 메뉴힌 등 대가의 텍스트가 많은 바이올린 학습서) 등의 대량의 바이올린 관련 데이터를 수집해야 합니다. 이를 위해서는 데이터 수집에 필요한 시간과 노력이 필요합니다.

- ChatGPT API를 사용하여 바이올린 레슨을 위한 GPT를 만들 때, 텍스트 분석 기술을 사용하여 데이터를 처리해야 합니다. 이를 위해서는 자연어 처리(NLP) 기술을 이해하고, 적용할 수 있어야 합니다. 또 ChatGPT API를 사용하여 모델을 학습하는 경우, 학습에 사용되는 하드웨어 및 시간에 제한이 있을 수 있습니다. 이를 극복하기 위해서는 대규모 데이터 세트를 작은 배치로 나누어 학습하는 등의 방법을 사용하여 모델 학습을 최적화해야 합니다. 또한 ChatGPT API를 사용하여 모델을 평가할 때, 모델의 성능을 측정하는 데 사용되는 메트릭과 평가 방법에 대한 이해가 필요합니다. 이를 위해서는 모델 성능 평가에 대한 전문적인 지식과 경험이 필요할 수 있습니다.

만약 인공지능이나 머신러닝에 대한 경험이 없으시다면 샵투스쿨의 왕초보! 텐서플로우 2.0 머신러닝 기초 강좌를 수강하신다면 (무료 강좌임) 전체 적인 머신러닝에 대한 기술적 이해력을 가질 수 있습니다.

챗GPT API를 이용한 작업 과정

- chatGPT API 등록: OpenAI의 chatGPT API를 사용하려면 먼저 API를 등록해야합니다. API를 등록하려면 OpenAI 웹 사이트에서 등록 프로세스를 따르고, 필요한 인증서 및 API 키를 받아야합니다. 일부 유료 서비스는 있지만, 계정 등록과 API key 생성은 무료입니다. 하지만 일부 제한 사항이 존재하며, 이를 해결하기 위해서는 유료 등급으로 업그레이드해야 합니다. 따라서, 계정 등록과 API key 생성은 무료이지만 더 많은 기능을 사용하려면 업그레이드가 필요합니다.API 등록을 위해 다음 단계를 따르세요.

- OpenAI 사이트에 로그인합니다. OpenAI 계정이 없는 경우, 계정을 생성해야 합니다. OpenAI의 공식 웹사이트 주소는 https://openai.com/ 입니다.

- 계정 로그인 후 OpenAI 대시보드로 이동합니다.

- 대시보드에서 API 탭을 선택합니다.

- API 탭에서 “Create API Key” 버튼을 클릭합니다.

- API 키를 생성하기 위해 지침을 따릅니다. 생성 시, 이메일 인증이 필요할 수 있습니다.

- API 키 생성이 완료되면, API 콘솔에서 API를 호출할 수 있는 정보를 볼 수 있습니다.

이제 API 등록이 완료되었으므로, API를 사용하기 위해 필요한 인증 정보를 사용하여 코드를 작성할 수 있습니다.

- 데이터 수집: 바이올린 교육용 GPT를 만들기 위해 많은 양의 데이터가 필요합니다. 이 데이터는 바이올린 교육용 책, 레슨 내용, 연주에 대한 내용 등을 포함할 수 있습니다.바이올린 교육용 GPT를 만들기 위해 필요한 데이터는 텍스트 데이터입니다. 따라서 아래 화면 캡처를 참고하세요. Build an application에서 “Text completion” 옵션을 선택해야 합니다. 연주 동영상이나 소리를 이용한 데이터는 OpenAI API로는 처리할 수 없으며, 오직 텍스트 데이터만 가능합니다.

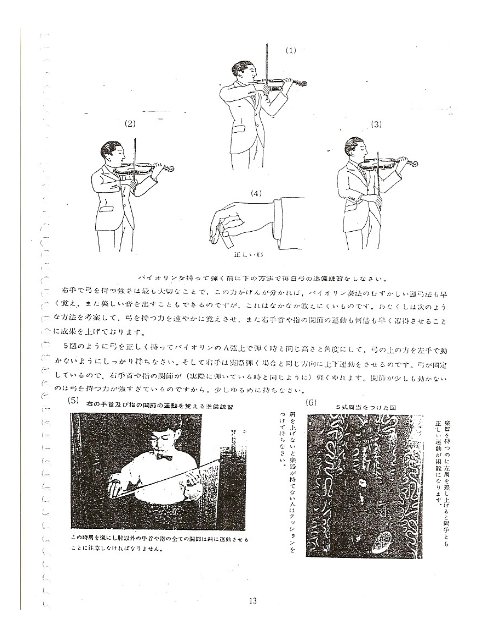

OpenAI의 GPT-3 API는 일반적으로 텍스트 형태로 입력된 데이터를 처리합니다. 따라서, 바이올린 교본의 경우에는 텍스트 형태로 변환한 후에 API에 입력해야 합니다. 만약 PDF 스캔 파일을 사용하고자 한다면, 먼저 PDF를 텍스트로 변환하는 작업이 필요합니다. 이 작업은 OCR (Optical Character Recognition) 프로그램을 사용하여 수행할 수 있습니다.일반적으로 사용되는 OCR 프로그램으로는 Adobe Acrobat, ABBYY FineReader, Readiris, Tesseract 등이 있습니다. 이 중 Tesseract는 오픈소스 기반으로 무료로 사용할 수 있는 OCR 엔진으로, 다양한 언어를 지원하고 있습니다. 다만, OCR 프로그램은 인식률이 100%가 되지 않을 수 있으므로, 인식률을 높이기 위해 여러 프로그램을 조합하여 사용하거나, 수동으로 수정하는 작업이 필요할 수 있습니다.

OpenAI의 GPT-3는 이미지 생성 및 처리와 같은 기능도 제공하지만, 그림에 대한 입력은 아직 지원하지 않습니다. 따라서 GPT-3 API를 사용하여 바이올린 교육용 GPT 모델을 구축하는 경우, 이미지를 텍스트로 변환한 후 모델에 입력해야 합니다.

일반적으로 이미지를 텍스트로 변환한다는 것은 이미지에 포함된 텍스트를 인식하고, 그것을 컴퓨터가 이해할 수 있는 문자로 변환하는 것을 의미합니다. 따라서 이미지에 포함된 텍스트를 추출하고, 그것을 활용하는 것이 가능합니다. 하지만 이미지 자체를 설명하는 것은 어려울 수 있습니다.GPT 모델은 주로 텍스트 데이터를 기반으로 학습하기 때문에, 연주 동영상이나 음원을 직접 입력하는 것은 어렵습니다. 하지만, 이러한 비디오나 오디오 자료를 텍스트로 변환한 뒤에 모델에 학습시키는 방법이 있습니다. 이를 위해 자동 음성인식 (Automatic Speech Recognition, ASR) 기술이나 영상에서의 문자 인식 (Optical Character Recognition, OCR) 기술 등을 사용하여 비디오나 오디오에서 텍스트 데이터를 추출하는 과정이 필요합니다. 추출된 텍스트 데이터를 GPT 모델에 학습시켜 음악이나 연주에 대한 텍스트 데이터를 생성하고, 이를 이용하여 교육할 수 있습니다.하지만, 이러한 방법으로 생성된 텍스트 데이터는 모델이 학습한 데이터의 정확도와 완전히 일치하지는 않을 수 있으며, 일부 정보의 손실이 발생할 수도 있습니다. 또한, 음악이나 연주와 같은 비디오나 오디오 자료를 텍스트로 변환하는 과정에서 인식 오류가 발생할 수 있으므로, 이러한 방법으로 생성된 데이터를 사용할 때에는 주의가 필요합니다.

시노자키 바이올린 교본 pdf 스캔의 예 - 데이터 정제: 데이터를 수집하면 다음 단계는 데이터를 정제하는 것입니다. 이 단계에서는 데이터를 노이즈에서 필터링하고 정규화하여 분석 가능한 형식으로 변환해야합니다.예를 들어 시노자키 교본 2권(개정판) 10페이지의 맨 상단의 text인 “매일 여러 번 반복해서 연습하십시오” 라는 문장을 정제하는 과정은 다음과 같습니다.

- 불필요한 정보 필터링: OCR을 통해 추출한 텍스트 데이터에서 필요하지 않은 정보(예: 이미지 캡션, 페이지 번호 등)를 필터링합니다.

- 텍스트 정규화: 추출한 텍스트 데이터를 정규화하여 데이터를 분석 가능한 형식으로 변환합니다. 이 단계에서는 스테밍(stemming), 불용어(stopwords) 제거, 대소문자 통일 등의 과정을 거쳐 정규화된 텍스트 데이터를 생성합니다.스테밍(stemming)은 단어의 어간(stem)을 추출하는 과정입니다. 즉, 같은 의미를 가지지만 다른 형태로 표현된 단어들을 같은 형태로 통일하여 분석을 용이하게 합니다. 예를 들어, “walking”, “walks”, “walked”와 같은 단어들은 모두 “walk”의 어간(stem)을 갖고 있으므로, 스테밍을 통해 모두 “walk”로 변환할 수 있습니다.불용어(stopwords)는 분석에 있어서 의미가 없거나 빈번하게 등장하여 분석에 방해가 되는 단어들을 말합니다. 예를 들어, 영어에서는 “the”, “a”, “an”, “in”, “at”과 같은 단어들이 불용어에 해당합니다. 이러한 불용어들은 분석에서 제거함으로써, 더 의미 있는 단어들에 집중할 수 있습니다.따라서, 예를 들어 “매일 여러 번 반복해서 연습하십시오”라는 문장에서 스테밍을 수행하면 “반복”, “연습”과 같은 어간(stem)들만 추출할 수 있습니다. 불용어 제거를 수행하면 “매일”, “여러”, “번”, “해서”, “하십시오”와 같은 불용어들은 제거되어 “반복”, “연습”만 남게 됩니다.

따라서, “매일 여러 번 반복해서 연습하십시오”와 같은 텍스트 데이터를 분석 가능한 형식으로 변환하려면 OCR을 통해 추출한 텍스트 데이터를 필터링하고, 정규화하며, 이를 바탕으로 텍스트 분석을 수행해야 합니다. - 텍스트 분석: 생성된 정규화된 텍스트 데이터를 바탕으로 텍스트 분석을 수행합니다. 이 단계에서는 텍스트 데이터를 어떻게 활용할 것인지에 따라서 다양한 방법으로 분석이 가능합니다. 예를 들어, 자연어 처리(NLP) 기술을 활용하여 텍스트 데이터의 감성 분석, 주제 분류, 문서 요약 등의 작업을 수행할 수 있습니다.

예를 들어 텍스트 분석에서 “반복”과 “연습”은 중요한 단어로 간주될 수 있습니다. 이러한 단어들은 주제 분류 작업에서 해당 문서가 음악 교육에 관한 것임을 나타내는 중요한 단서가 될 수 있습니다. 또한, 감성 분석에서는 이러한 단어들이 긍정적인 의미를 지닐 수 있습니다. 예를 들어 “반복”이라는 단어는 어떤 기술을 반복적으로 연습함으로써 성취감을 느끼는 것과 같이 긍정적인 의미를 지닐 수 있습니다. 따라서 이러한 단어들을 활용하여 텍스트 분석을 수행할 수 있습니다.반복 연습에 대한 감성 분석 예시로는, “반복적인 연습은 지루하고 지치지만, 도전적인 과제를 해결하고 나면 성취감과 자신감을 얻게 된다” 라는 문장을 예로 들 수 있습니다. 이 문장에서 “반복적인 연습”이라는 키워드는 부정적인 감성을 나타낼 수 있지만, 이후의 문장에서 긍정적인 감성으로 전환이 되기 때문에 전체적으로는 긍정적인 감성을 나타냅니다.주제 분류 예시로는, “반복적인 연습의 중요성”이라는 주제로 분류한다면, 문장 속에서 “반복”, “연습”과 같은 키워드를 추출해 이를 중심으로 분석을 진행할 수 있습니다.문서 요약 예시로는, “반복적인 연습의 효과”라는 주제로 요약을 한다면, 이 문장에서 “반복적인 연습은 지루하고 지치지만, 도전적인 과제를 해결하고 나면 성취감과 자신감을 얻게 된다”라는 구절을 요약할 수 있습니다. 이를 요약하면 “반복적인 연습을 통해 성취감과 자신감을 얻을 수 있다”와 같이 요약할 수 있습니다.

- 모델 학습: 모델 학습 단계에서는 GPT 모델을 데이터에 적합하도록 조정합니다. 이 단계에서는 OpenAI의 chatGPT API를 사용하여 모델을 훈련하고, 훈련 세트에서 성능을 최적화하고, 과적합을 방지하는 하이퍼파라미터를 조정합니다.

모델 학습 단계에서는 훈련 데이터셋에 적합하도록 모델의 파라미터를 조정하여 성능을 최적화하고, 과적합을 방지합니다. 예를 들어, 입력으로 받은 텍스트 데이터에서 모델이 언어의 문맥과 관련된 규칙과 패턴을 학습할 수 있도록 하이퍼파라미터를 조정합니다. 예를 들어, GPT 모델의 layer 개수, 학습률(learning rate), 배치 크기(batch size), 에포크 수(epoch) 등을 조정하여 최적의 하이퍼파라미터를 찾습니다.과적합(overfitting)은 모델이 훈련 데이터셋에 대해서는 높은 정확도를 보이지만, 새로운 데이터에 대해서는 일반화(generalization) 능력이 떨어지는 문제를 말합니다. 예를 들어, 모델이 학습 데이터셋에서 우리가 정제한 키워드 “반복”과 “연습”을 잘 예측하지만, 새로운 데이터에서는 예측 성능이 낮아질 수 있습니다. 이를 방지하기 위해 모델의 복잡도를 줄이는 방법, 데이터셋을 다양하게 확보하는 방법 등이 있습니다. - 모델 테스트: 모델 학습이 완료되면 테스트 세트에서 모델의 정확성을 테스트합니다. 이 단계에서는 모델의 성능이 만족스러운지 확인하고, 추가 조정이 필요한 경우 모델을 다시 훈련할 수 있습니다.

chatGPT API는 텍스트를 입력받아 대화를 생성하는 모델입니다. 따라서 chatGPT API를 사용하여 모델 테스트를 수행하려면, 테스트 세트에서 추출한 텍스트 데이터를 입력으로 제공하고, 생성된 대화 결과를 평가하여 모델의 정확성을 확인할 수 있습니다.예를 들어, 테스트 세트에서 추출한 다양한 주제의 질문을 chatGPT API에 입력하고, 생성된 대화 결과가 원하는 대답과 일치하는지 확인할 수 있습니다. 또한, 생성된 대화 결과의 자연스러움과 일관성을 평가하여 모델의 성능을 확인할 수 있습니다. - 모델 배포: 모델을 배포하기 전에 API의 사용 조건에 따라 라이선스 및 사용 권한을 검토해야합니다. 모델을 배포하기 전에 웹 서버와 같은 호스팅 서비스를 설정해야합니다.

OpenAI의 GPT API를 사용하기 위해서는 API Key를 발급받아야 하며, 발급받은 Key를 사용하여 API를 호출하는 것으로 사용 권한을 확인합니다.웹 서버는 다양한 호스팅 서비스에서 가능합니다. 일반적으로 흔한 Linux 호스팅 역시 가능합니다.OpenAI의 GPT API의 가격은 시간당 요금으로 책정됩니다. 2023년 2월 기준으로, GPT-3 API의 경우 초당 4센트에서 16센트 사이의 가격이 적용되며, 사용량에 따라 다른 요금제가 존재합니다. 따라서 월 10만건의 질문을 한다면 대략 4,000에서 16,000 달러 사이의 비용이 들 것으로 예상됩니다.OpenAI의 GPT API는 REST API로 제공되며, 따라서 프론트엔드 및 백엔드 어떤 플랫폼에서든 API를 호출하여 사용할 수 있습니다. WordPress나 Django 등 다양한 플랫폼에서 API를 사용할 수 있습니다.

예를 Django REST framework를 사용하여 OpenAI의 GPT API를 호출할 수 있습니다. Django REST framework은 Python으로 작성된 웹 프레임워크이며 RESTful API를 구축하는 데 사용됩니다. OpenAI의 GPT API는 HTTP 요청을 통해 호출되므로 Django REST framework의 HTTP 요청 기능을 사용하여 GPT API와 상호 작용할 수 있습니다.Django REST framework을 사용하면 API 엔드 포인트를 정의하고 해당 엔드 포인트에서 GPT API에 대한 요청을 보내는 데 필요한 모든 기능을 제공할 수 있습니다. 이를 통해 Django 애플리케이션에서 OpenAI의 GPT API와 상호 작용하는 데 필요한 모든 기능을 구현할 수 있습니다. 이와 관련된 샵투스쿨의 강좌로는 1시간만에 장고 플러터 연동 모바일 앱 만들기 – 장고 DRF(Django Rest Framework)와 모바일 앱 연동이 있으며 여러분은 첫번째 섹션의 장고측 서버작업 부분을 보시면 api 연동에 대한 이해력을 가지게 됩니다.

- API 사용: 모델이 배포되면 바이올린 교육용 GPT를 사용할 수 있습니다. 이를 위해서는 API를 호출하고 모델의 입력 데이터를 전달해야합니다. API는 모델을 실행하고 적절한 출력을 반환합니다.

웹 뿐만 아니라 OpenAI API를 이용해서 ChatGPT 서비스를 모바일 앱에서도 사용할 수 있습니다. OpenAI는 REST API를 제공하므로, 대부분의 클라이언트 라이브러리나 SDK를 사용하여 API를 호출할 수 있습니다. 예를 들어, Flutter 애플리케이션에서는 http 패키지를 사용하여 OpenAI API를 호출할 수 있습니다. 이를 통해 모바일 앱에서도 ChatGPT 서비스를 구현할 수 있습니다. 다만, API 사용량 제한과 관련한 가격 정책을 고려하여 개발 및 서비스를 진행해야 합니다.

이와 같은 단계를 따라서 바이올린 교육용 GPT를 만들 수 있습니다.