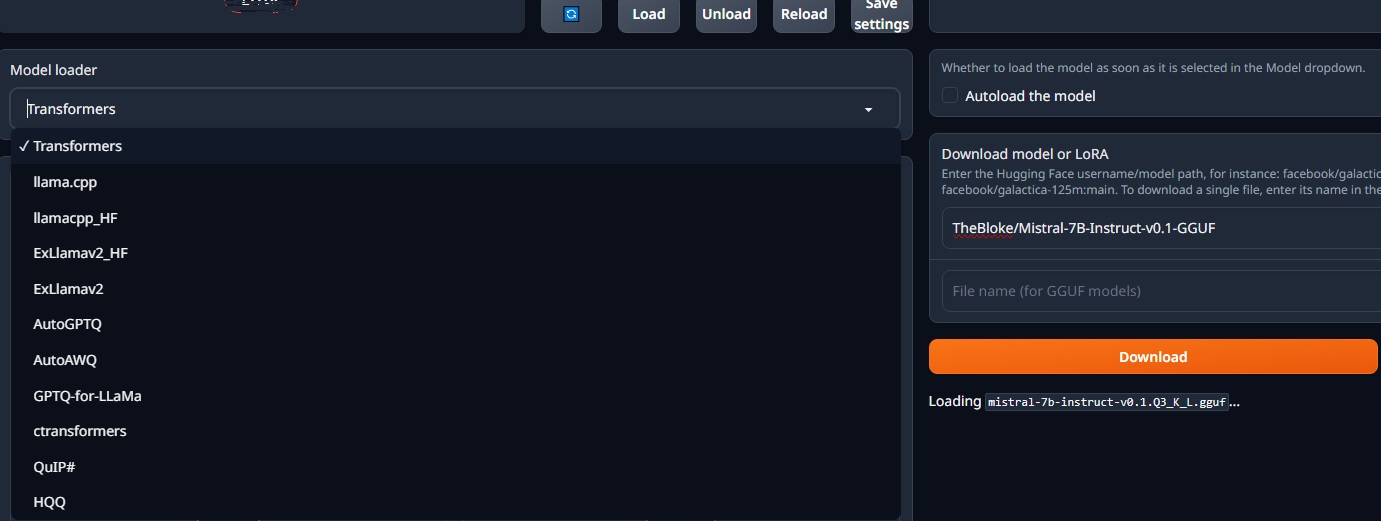

oobabooga 웹 UI의 모델 로더 옵션 설명

oobabooga 웹 UI의 모델 로더는 다양한 형식의 텍스트 생성 모델을 불러와 사용할 수 있게 해주는 기능입니다.

- “Transformers”: Hugging Face Transformers 라이브러리를 사용하는 기본 로더입니다. 대부분의 모델과 호환됩니다.

- “llama.cpp”: TheBloke/Mistral-7B-Instruct-v0.1-GGUF 모델과 같은 GGUF 형식의 모델을 로딩하는 데 사용되는 고성능 로더입니다.

- “llamacpp_HF”: 아직 설명이 정확하게 확인되지 않았지만, llama.cpp와 Hugging Face 라이브러리를 함께 사용하는 하이브리드 로더の可能性이 있습니다.

- “ExLlamav2_HF”: 아직 정확한 정보는 없지만, ExLlamav2라는 LLM 모델과 Hugging Face 라이브러리를 사용하는 로더같습니다.

- “ExLlamav2”: 아마도 ExLlamav2 모델을 독립적으로 로딩하는 로더일 것입니다. (추가 정보 필요)

- “AutoGPTQ”: GPT-Q 형식의 모델을 자동으로 로딩하는 Hugging Face 라이브러리 기반 로더입니다.

- “AutoAWQ”: AWQ 형식의 모델을 자동으로 로딩하는 Hugging Face 라이브러리 기반 로더입니다.

- “GPTQ-for-LLaMa”: LLaMa와 함께 사용하도록 최적화된 GPT-Q 형식의 모델을 로딩하는 로더 같습니다. (추가 정보 필요)

- “ctransformers”: 파이썬 라이브러리 ctransformers를 사용하여 LLM 모델을 로딩하는 로더입니다.

- “QuIP#”: 아직 정확한 정보는 없지만, QuIP라는 프로젝트와 관련이 있을 수 있습니다. (추가 정보 필요)

- “HQQ”: 현재 사용 목적이 명확하지 않습니다. (추가 정보 필요)

요약 정리:

- 특별한 이유가 없다면 “Transformers” 옵션을 사용하는 것이 좋습니다. 대부분의 모델과 호환되며, 사용이 간편합니다.

- 그러나 예를 들어 특징 모델 로더를 사용하라고 하면 그것을 써야 합니다. 예를 들어 미스트랄의 경우 TheBloke/Mistral-7B-Instruct-v0.1-GGUF 모델을 사용할 경우에는 반드시 “llama.cpp” 옵션을 선택해야 합니다.

이처럼 다양한 모델 로더들이 존재하는 이유와 특징은?

1. 다양성 제공: 서로 다른 모델 아키텍처 및 학습 방법을 사용하는 모델들이 있기 때문에 다양한 모델 로더가 필요합니다. 예를 들어, Hugging Face의 Transformers 라이브러리는 트랜스포머 모델을 지원하는 반면, llama.cpp는 특정한 양자화 기법을 적용한 모델을 로드하는 데 사용됩니다.

2. 특정 용도에 맞는 최적화: 각 모델 로더는 특정 용도나 요구 사항에 맞게 최적화되어 있습니다. 예를 들어, llama.cpp는 메모리나 계산 능력이 제한된 장치에서 모델을 효율적으로 실행하기 위한 최적화를 제공합니다.

3. 성능 및 기능: 각 모델 로더는 해당하는 모델 아키텍처 및 학습 방법에 대해 최적화된 성능과 기능을 제공합니다. 예를 들어, ctransformers는 CUDA GPU 가속을 지원하여 모델 실행 속도를 향상시킬 수 있습니다.

4. 개발자 커뮤니티와 호환성: 각 모델 로더는 해당하는 개발자 커뮤니티와의 호환성을 유지하고, 해당 프레임워크나 라이브러리의 업데이트나 확장을 반영합니다. 이는 개발자가 다양한 환경에서 모델을 개발하고 실행할 때 필요한 유연성을 제공합니다.

따라서, 다양한 모델 로더들이 존재하는 것은 모델 개발과 실행에 필요한 다양성과 유연성을 제공하기 위함입니다.